Cord Arnold und Matthias Kling • 12/2023 • Seite 22 • DPG-Mitglieder

Cord Arnold und Matthias Kling • 12/2023 • Seite 22 • DPG-MitgliederNobelpreis Physik: Stoppuhr für Elektronen

Der diesjährige Nobelpreis für Physik zeichnet Forschungen aus, welche die

entscheidenden Grundlagen für die Attosekundenphysik gelegt haben.

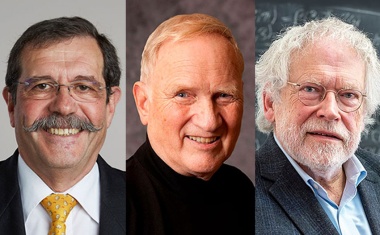

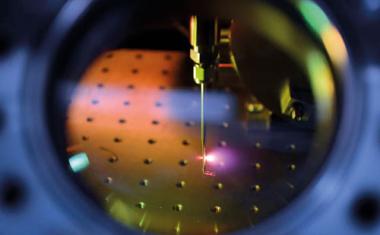

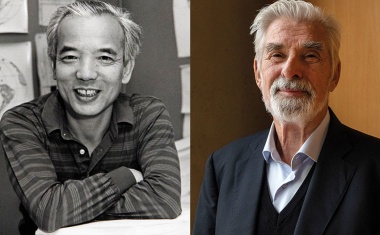

Die Historie der Attosekundenphysik ist eng verbunden mit Entwicklungen in der Lasertechnik. Pierre Agostini, Ferenc Krausz und Anne L’Huillier haben maßgeblich dazu beigetragen, Attosekundenpulse erzeugen zu können, mit denen sich die Dynamik von Elektronen in Materie untersuchen lässt. Ihnen gilt unser herzlicher Glückwunsch, genau wie allen anderen, die zur Entwicklung des Gebietes beigetragen haben!

Seit jeher ist es faszinierend, Phänomene zu verstehen, die sich nicht mit unseren Sinnen begreifen lassen, weil sie auf zu kleinen oder zu schnellen Skalen passieren oder beides gleichzeitig. Tatsächlich gibt es eine deutliche Korrelation zwischen der Größe eines Objektes und der Geschwindigkeit seiner zugrunde liegenden Dynamik. Menschen sind gewöhnt an Abläufe auf der Skala von Sekunden oder Sekundenbruchteilen. Für schnellere Dynamik benötigen wir Werkzeuge, wie Kameras mit kurzer Belichtungszeit oder stroboskopische Beleuchtung (Abb. 1). Nähert man sich der Größenskala von Molekülen und einzelnen Atomen, liegt die Dynamik für das Bilden und Aufbrechen chemischer Bindungen im Femtosekunden-Bereich (1 fs = 10–15 s). Das Sichtbarmachen solcher Prozesse würdigte 1999 der Chemie-Nobelpreis für Ahmed Zewail. Noch schneller ist die Dynamik der Elektronen: Im Bohrschen Atommodell lässt sich der Umrundung eines Wasserstoff-Atoms durch ein Elektron eine Dauer von etwa 150 Attosekunden (1 as = 10–18 s) zuordnen.

Der diesjährige Nobelpreis in Physik würdigt die Entwicklung von Werkzeugen, die es erlauben, die Dynamik von Elektronen auf der Attosekunden-Zeitskala sichtbar zu machen und zu untersuchen. Ausgangspunkt war die Entwicklung immer intensiverer Laser, in deren Folge in den 1970er- und 1980er-Jahren der Untersuchung von Ionisationsprozessen in starken Laserfeldern viel Aufmerksamkeit gewidmet wurde. Pierre Agostini hatte dazu mit der Entdeckung der Above-Threshold Ionisation (ATI) beigetragen [1]. Später sollte sich herausstellen, dass dieser Prozess eng mit der Erzeugung von Attosekundenpulsen verknüpft ist. (...)

Alf Mews und Wolfgang J. Parak • 12/2023 • Seite 27

Alf Mews und Wolfgang J. Parak • 12/2023 • Seite 27Nobelpreis Chemie: Die Größe macht‘s

Der Nobelpreis für Chemie zeichnet grundlegende Arbeiten zur Entdeckung und Synthese von Quantenpunkten aus.

Quantenpunkte bestehen aus zehn bis zehntausend Atomen eines Halbleitermaterials und tragen wegen ihrer Größe auch die Bezeichnung Nanokristalle. Sie existieren eingebettet in Festkörpern sowie als Kolloide in Lösung. Kolloidale Quantenpunkte sind an der Oberfläche mit Molekülen belegt; da sie sehr viel kleiner als die Wellenlänge sichtbaren Lichts sind, erscheinen sie als transparente farbige Lösungen. Die Nanokristalle lassen sich gezielt mit einer Methode herstellen, die auf den Arbeiten des jüngsten der diesjährigen Chemie-Nobelpreisträger, Moungi G. Bawendi, beruht. Bei der Entdeckung und ersten Synthese von Quantenpunkten haben Louis E. Brus und Aleksei I. Ekimov entscheidende Beiträge geleistet. Allen dreien möchten wir mit diesem Beitrag herzlich gratulieren.

Wie so oft in der Geschichte der Wissenschaft geht auch die Entdeckung chemisch hergestellter Quantenpunkte nicht auf eine Person zurück, sondern wurde an verschiedenen Orten unabhängig voneinander vorangetrieben. So untersuchte Aleksei Ekimov in den frühen 1980er-Jahren die Wachstumskinetik von Kupferchlorid-Mikrokristallen in Glasschmelzen. Dabei beobachtete er, dass die Gläser je nach den Bedingungen, unter denen die Reaktion ablief, unterschiedliche Anteile des ultravioletten und sichtbaren Licht absorbierten. 1981 zeigte er, dass sich dieser Effekt auf im Glas eingeschlossene, verschieden große Nanokristalle aus Kupferchlorid zurückführen lässt [1]. Leider waren die winzigen Partikel nicht frei zugänglich und die Absorptionswellenlänge verschob sich nur um wenige Nanometer. Dennoch gelang es, die Größe der Nanokristalle eindeutig mittels Lichtstreuexperimenten nachzuweisen und damit den Größenquantisierungseffekt in Quantenpunkten erstmalig zu zeigen.

Zeitgleich fanden jenseits des eisernen Vorhangs in der Gruppe des 2012 verstorbenen Arnim Henglein Experimente statt, um photogenerierte Elektronen in kleinen Halbleiterpartikeln für Reduktions- und Oxidationsprozesse zu nutzen. Am Hahn-Meitner-Institut in West-Berlin, das heute zum Helmholtz-Zentrum Berlin gehört, gelang die Synthese sehr kleiner Metall- und Halbleiterpartikel mit unterschiedlichen kolloidchemischen Ansätzen. Das ursprüngliche Ziel war es, durch eine geringe Größe der Partikel die Diffusionswege der Ladungsträger an die Oberfläche der Teilchen zu verkürzen. Das sollte die photochemischen Prozesse, die zum Beispiel zur photokatalytischen Wasserspaltung führen können, möglichst effektiv gestalten. Im Rahmen dieser Entwicklungen entstanden Synthesen, wie die Reaktion gelöster Cadmiumsalze mit Sulfiden bei sehr hohen pH-Werten, um die Reaktivität der Ausgangsverbindungen zu erhöhen und damit möglichst kleine Partikel herzustellen. Dabei wunderten sich Henglein und seine Gruppe, dass die Reaktion nicht zu einer für Cadmiumsulfid charakteristischen Gelbfärbung führte, sondern teilweise farblose Lösungen hervorbrachte. Erst spektroskopische Untersuchungen zeigten, dass sich die Absorptionswellenlänge aus dem sichtbaren in den UV-Bereich verschoben hatte, da für solch kleine, kolloidal gelöste Kristalle die Energie des sichtbaren Lichts nicht mehr ausreicht, um die Ladungsträger optisch anzuregen. (...)

Thorsten Schumm und Harald Weinfurter • 12/2022 • Seite 24 • DPG-Mitglieder

Thorsten Schumm und Harald Weinfurter • 12/2022 • Seite 24 • DPG-MitgliederRevolutionäre der Quantenphysik

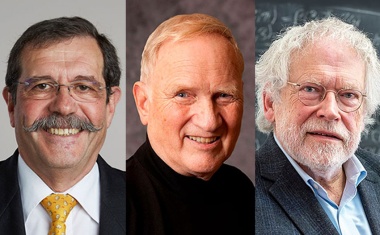

Alain Aspect, John Clauser und Anton Zeilinger haben mit ihren Experimenten wesentliche Grundlagen für die Quantentechnologie gelegt.

Alain Aspect, John F. Clauser und Anton Zeilinger teilen sich den diesjährigen Physik-Nobelpreis für ihre „Experimente mit verschränkten Photonen, welche die Verletzung der Bell-Ungleichungen nachwiesen und den Weg für die Quanteninformationswissenschaft ebneten“.

Erwin Schrödinger prägte mit „Verschränkung“ den Begriff für ein Phänomen der Quantenphysik, das auch heute noch tiefgehende Fragen aufwirft, aber gleichzeitig zu einer der wichtigsten Ressourcen der Quantentechnologie geworden ist [1]. Albert Einstein wies 1935 zusammen mit Boris Podolsky and Nathan Rosen anhand ihres berühmten Gedankenexperiments [2] darauf hin, dass der lokal-realistische Standpunkt der klassischen Physik bei der Verschränkung infrage gestellt wird. Ein möglicher Ausweg wäre es, den Teilchen individuelle Eigenschaften zuzuschreiben, die in „verborgenen Variablen“ definiert sind. Diese Variablen würden das Verhalten bei Messungen steuern und damit den quantenmechanischen Zufall vortäuschen. Allerdings – darauf hat Einstein bereits hingewiesen – wäre für die Beschreibung verschränkter Paare auch eine „spukhafte Fernwirkung“ notwendig, um die Information schneller als mit Lichtgeschwindigkeit zu übermitteln.

John F. Clauser und Stuart Freedman (1944 – 2012) befassten sich Anfang der 1970er-Jahre an der UC Berkeley mit Bells Ideen. In ihrem Experiment [4] werden jeweils die Photonenpaare, die bei einer Zerfallskaskade im Kalzium entstanden, auf einen Polarisator geleitet (parallele Glasplatten unter Brewster-Winkel), der nur eine bestimmte (lineare) Polarisationsrichtung durchlässt. Damit gelang Clauser und Freedman ein Analogon zum Stern-Gerlach-Experiment, mit dem sie zeigen konnten, dass die gemessenen Korrelationen gegen Freedmans Variante der Bell-Ungleichung verstießen und somit einen starken Hinweis dafür lieferten, dass sich die Quantenmechanik nicht durch eine lokale Theorie mit versteckten Variablen (engl.: local hidden-variable (LHV) theory) ersetzen ließ. (...)

Den Weg aus den reinen Gedankenexperimenten wies in den 1960er-Jahren der irische Theoretiker John Stewart Bell [3]. Er entwickelte die nach ihm benannte mathematische Ungleichung, die besagt, dass bei Vorhandensein verborgener Variablen und ohne spukhafte Fernwirkungen die Korrelation zwischen den Ergebnissen von Messungen an einer großen Zahl von Teilchenpaaren niemals einen bestimmten Wert überschreitet. Die Quantenmechanik sagt jedoch voraus, dass die Messergebnisse von verschränkten Teilchenpaaren gegen die Bellsche Ungleichung verstoßen und es daher erlauben, die Gültigkeit lokal-realistischer Konzepte zu überprüfen.

Kurt Binder • 12/2021 • Seite 31 • DPG-Mitglieder

Kurt Binder • 12/2021 • Seite 31 • DPG-MitgliederWanderungen in zerklüfteten Energie-Landschaften

Giorgio Parisi erhält eine Hälfte des diesjährigen Physik-Nobelpreises für seine Theorien komplexer Systeme.

Mit dem Nobelpreis für Physik 2021 wird der italienische Physiker Giorgio Parisi ausgezeichnet für „die Entdeckung des Zusammenspiels von Unordnung und Fluktuationen in physikalischen Systemen vom atomaren bis zum planetarischen Maßstab“. Sein zentraler Beitrag besteht darin, eine Molekularfeldtheorie für Spingläser entwickelt zu haben [1].

Um Giorgio Parisis Leistung möglichst verständlich zu erläutern, muss hier etwas weiter ausgeholt werden: Spingläser sind magnetische Materialien, die erst seit rund 50 Jahren bekannt sind, das Phänomen des Ferromagnetismus dagegen seit Jahrtausenden. Jedem geläufig ist die Magnetnadel im Kompass, die im Magnetfeld der Erdkugel die Richtung zum Nordpol anzeigt. Seit der Weiss’schen Molekularfeldtheorie (1907) wissen wir, dass die magnetischen Momente der Eisen-Atome durch Wechselwirkungen gekoppelt sind. In der Folge richten sich diese Momente spontan parallel aus. Erst bei hohen Temperaturen, oberhalb der Curie-Temperatur Tc, zerstören thermische Fluktuationen diese magnetische Ordnung.

Werner Heisenberg (1928) erklärte diese Wechselwirkung mittels Quantenmechanik. Die Kopplung kann auch das umgekehrte Vorzeichen haben, was eine antiparallele Ausrichtung benachbarter magnetischer Momente (die wir hinfort als „Spins“ bezeichnen wollen) hervorruft, also Antiferromagnetismus. Methoden wie Neutronenbeugung können die Bragg-Reflexe dieser Überstruktur des Kristallgitters nachweisen [2]. Bei Annäherung an die Néel-Temperatur TN, unterhalb der diese Ordnung der Spins auftritt, zeigt sich diese Phasenumwandlung auch durch eine Spitze der magnetischen Suszeptibilität bei TN [3]. Diese Kenngröße misst die Magnetisierung, die ein kleines angelegtes Magnetfeld in einem Material bewirkt. (...)

Jochem Marotzke • 12/2021 • Seite 26 • DPG-Mitglieder

Jochem Marotzke • 12/2021 • Seite 26 • DPG-MitgliederPhysik und Klima

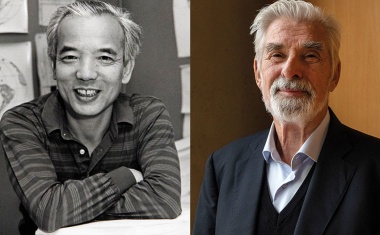

Zum Physik-Nobelpreis 2021 an Syukuro Manabe und Klaus Hasselmann

Eine Hälfte des Nobelpreises für Physik 2021 erhalten Syukuro (Suki) Manabe und Klaus Hasselmann „für die physikalische Modellierung des Erdklimas, für die Quantifizierung seiner Schwankungen und die verlässliche Vorhersage der Erderwärmung“. Es ist der erste Nobelpreis für Umweltphysik und der zweite in den Umweltwissenschaften nach dem Chemie-Nobelpreis 1995 für die Erklärung des Ozonlochs an Paul Crutzen, Mario Molina und Sherwood Rowland.

Suki Manabe und Klaus Hasselmann sind so eminente Figuren in der Klimaphysik, dass ich sie beide persönlich kenne. Klaus Hasselmann war ein steter Begleiter meines eigenen beruflichen Werdegangs, aber die Ideengeschichte dieses Nobelpreises begann mit Suki Manabe. Daher möchte ich diesen Beitrag auch mit ihm beginnen.

Der Wirbelwind

Suki Manabe feierte am 25. September seinen 90. Geburtstag. Er stammt aus Japan, hat aber praktisch sein gesamtes Berufsleben in den USA verbracht – überwiegend in Princeton, New Jersey – abgesehen von einer kurzen Rückkehr nach Japan nach seiner offiziellen Pensionierung. Die meiste und produktivste Zeit in Princeton verbrachte er nicht an der berühmten Universität, sondern am – außerhalb der Fachwelt weitgehend unbekannten – Geophysical Fluid Dynamics Laboratory (GFDL). Diese Einrichtung der Wetterbehörde der USA genießt innerhalb des Fachs einen legendären Ruf. Der ebenso legendäre erste Direktor Joseph Smagorinsky versammelte Ende der 1950er-Jahre die weltweit herausragendsten Talente am GFDL, um numerische Modelle für Atmosphäre und Ozean zu entwickeln. Als einer von ihnen genoss Suki Manabe praktisch völlige Freiheit, um seine wissenschaftlichen Ziele zu verfolgen. 1969 gelang es der Gruppe um ihn und um den Ozeanmodellierer Kirk Bryan, das erste gekoppelte Zirkulationsmodell für Atmosphäre und Ozean zu erstellen [1].

In Manabes nobelpreisgekrönter Arbeit geht es jedoch um eine viel fundamentalere Frage: Er benannte als Erster die unverzichtbaren Prozesse, um die Folgen einer Erhöhung der CO2-Konzentration in der Atmosphäre theoretisch vorherzusagen. Unter den damals vergleichsweise bescheidenen Umständen fasste er die Prozesse in numerischen Modellen zusammen und leitete aus ihnen wichtige Ergebnisse her. (...)

Domenico Giulini • 12/2020 • Seite 24 • DPG-Mitglieder

Domenico Giulini • 12/2020 • Seite 24 • DPG-MitgliederDie Realität Schwarzer Löcher

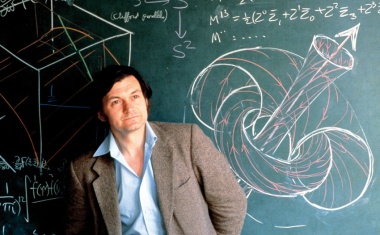

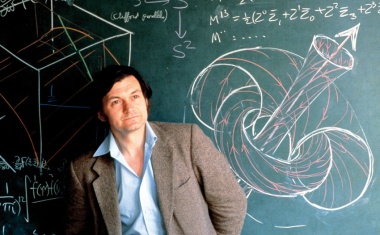

Eine Hälfte des Physik-Nobelpreises 2020 geht an Roger Penrose für seine Entdeckung,dass Schwarze Löcher eine robuste Vorhersage der Allgemeinen Relativitätstheorie sind.

„It will be shown that, after a certain critical condition has been fulfilled, deviations from spherical symmetry cannot prevent space-time singularities from forming.“ So fasste der 33-jährige Roger Penrose die wesentliche Erkenntnis einer nur zweieinhalb Seiten umfassenden Arbeit zusammen, die Anfang 1965 erschien [1]. Für die theoretischen Konsequenzen dieser Erkenntnis erhält er nun 55 Jahre später den Nobelpreis für Physik.

In einer Arbeit von 1969 schrieb Roger Penrose fast schon prophetisch [2, S. 1162]: „I only wish to make a plea for ‚black holes‘ to be taken seriously and their consequences to be explored in full detail. For who is to say, without careful study, that they cannot play some important part in the shaping of observed phenomena?“ Damals gab es noch keine Beobachtungsindizien auf die Existenz Schwarzer Löcher, wie sie nun in überzeugender Weise von den Gruppen Reinhard Genzels und Andrea Ghez’ geliefert wurden. Dass Einsteins Allgemeine Relativitätstheorie zu Instabilitäten kompakter Sterne führt, die in einer Newtonschen Beschreibung keine Entsprechung haben, war dagegen bekannt [3 – 5] und ist qualitativ leicht einzusehen. Denn die Schwere nimmt relativistisch mit dem Druck zu. Unter Umständen ist dies durch keinen weiteren Druckaufbau kompensierbar, eben aufgrund der erneut zunehmenden Schwere. In diesem Fall kommt es zum Gravitationskollaps des Sterns.

Was aber kann ein möglicher Endzustand dieser Kontraktion sein? Darauf sollte die Allgemeine Relativitätstheorie eine Antwort wissen. In der Tat! Stellt man sich der Einfachheit halber vor, der Stern sei sphärisch symmetrisch und kollabiere streng radial, dann muss auch das Endprodukt sphärisch symmetrisch und eine Lösung der quellenfreien Einsteinschen Feldgleichungen sein – die Quelle ist ja kollabiert. In diesem Fall gibt es eine eindeutige Antwort, die ebenfalls lange bekannt war. Es ist nämlich ein mathematischer Satz der Allgemeinen Relativitätstheorie, dass es genau eine einparametrige Schar solcher Lösungen gibt, die Karl Schwarzschild bereits 1916 gefunden hatte [6]. Diese beschreibt das Gravitationsfeld eines sphärischsymmetrischen Sterns außerhalb der Quelle und wird normalerweise unterhalb der Sternoberfläche durch eine weitere Lösung (Innenraumlösung) fortgesetzt. Diese kann nicht mehr eindeutig sein, sondern hängt sensibel vom jeweiligen Materiemodell ab. (...)

Karl M. Menten • 12/2020 • Seite 28 • DPG-Mitglieder

Karl M. Menten • 12/2020 • Seite 28 • DPG-MitgliederBlick ins Zentrum

Reinhard Genzel und Andrea Ghez haben das extrem massereiche Schwarze Loch im Herzen der Milchstraße charakterisiert.

Roger Penrose hat bewiesen, dass die Allgemeine Relativitätstheorie das Entstehen Schwarzer Löcher vorhersagt. Die astronomischen Untersuchungen von Reinhard Genzel und Andrea Ghez haben entscheidend dazu beigetragen, dass wir zweifelsfrei wissen, dass sich im Zentrum der Milchstraße ein extrem massereiches Schwarzes Loch befindet.

In unserem Universum kommen Schwarze Löcher in zwei sehr unterschiedlichen Formaten vor. Zum einen entstehen sie beim Kollaps eines massereichen Sterns als Überrest einer Supernovaexplosion. Die Masse dieser Schwarzen Löcher beträgt bis zu mehrere Dutzend Sonnenmassen. Verschmelzen zwei dieser stellaren Schwarzen Löcher, entstehen Gravitationswellen; ihr erstmaliger direkter Nachweis wurde mit dem Physik-Nobelpreis 2017 ausgezeichnet. Zum anderen befinden sich Schwarze Löcher im Zentrum von Galaxien. Ihre Massen entsprechen der millionen- oder gar milliardenfachen Sonnenmasse. Ein populäres Beispiel ist das Schwarze Loch im Zentrum der aktiven Galaxie Messier 87: Sein „Foto“ faszinierte im letzten Jahr die Weltöffentlichkeit. Seit den 1960er-Jahren ist bekannt, dass Quasare die energiereichen Zentren aktiver Galaxien bilden: Sie setzen in einer sehr kompakten Region so viel Energie frei wie ganze Galaxien. Als Ursache kommt dafür nur die potentielle Energie infrage, die frei wird, wenn Materie in das extreme Gravitationspotential eines riesigen Schwarzen Lochs stürzt. Dabei entsteht intensive Radiostrahlung, die für Messier 87 und viele andere Fälle nachweisbar ist. Das stärkte die Vermutung, dass sich im Zentrum vieler, vielleicht sogar aller Galaxien supermassereiche Schwarze Löcher befinden – auch in unserer Milchstraße. (...)

Joachim Wambsganß • 12/2019 • Seite 24

Joachim Wambsganß • 12/2019 • Seite 24Unser Platz im Universum

Der diesjährige Physik-Nobelpreis würdigt theoretische Entwicklungen in der Kosmologie und die Entdeckung des ersten Exoplaneten um einen sonnenähnlichen Stern.

Der Physik-Nobelpreis wird in diesem Jahr vergeben für Beiträge zum Verständnis der Evolution des Universums und des Platzes der Erde im Kosmos: Eine Hälfte des Preises geht an den kanadischen Kosmologen James Peebles für seine theoretischen Entdeckungen auf dem Gebiet der physikalischen Kosmologie. Die andere Hälfte teilen sich die beiden Schweizer Astronomen Michel Mayor und Didier Queloz für die Entdeckung des ersten extrasolaren Planeten, der einen sonnenähnlichen Stern umkreist.

Jim Peebles hat über viele Jahrzehnte wichtige Beiträge zur Kosmologie und zur großräumigen Struktur des Universums geliefert. Nach dem Grundstudium in seiner Heimat Manitoba in Kanada war er als Graduate Student nach Princeton gegangen. Zusammen mit seinem Doktorvater Robert Dicke sagte Peebles 1965 die Mikrowellenhintergrundstrahlung als „Echo des Urknalls“ vorher [1]. Dies geschah wohl unabhängig von den früheren Arbeiten von Gamow, Alpher und Herman und etwa zeitgleich mit der Entdeckung der 3K-Strahlung, die aus allen Richtungen des Himmels zu uns kommt, durch Arno Penzias und Robert Wilson – eine Leistung, die 1978 mit dem Physik-Nobelpreis gewürdigt wurde. Im Abstract schreibt Peebles: “There is good reason to expect the presence of black-body radiation in an evolutionary cosmology, and it may be possible to observe such radiation directly“. 1970 sagte Peebles zusammen mit Jer Yu – etwa zeitgleich, aber unabhängig von Sunyaev und Zel‘dovich – die Temperaturschwankungen im kosmischen Mikrowellenhintergrund vorher [2]. Deren detaillierte Beobachtung und Berechnung haben entscheidend dazu beigetragen, die Eigenschaften unseres Universums zu verstehen. Damit hatte Peebles ein Fenster in das sehr frühe Universum eröffnet, das experimentell und theoretisch immer präziser untersucht, beschrieben und verstanden wurde. Die Satelliten COBE (Nobelpreis 2006 für John Mather und George Smoot), WMAP und Planck haben dazu großartige Daten geliefert (Abb. 1).

Der Theoretiker Peebles beschäftigte sich zudem mit dem Modell des heißen Urknalls, er dachte nach über die primordiale Nukleosynthese und berechnete, dass in dieser frühen Phase des Universums Helium entstehen und etwa 25 % des Massenbudgets ausmachen sollte. Er war einer der ersten, die sich quantitativ mit der hierarchischen Struktur des Kosmos beschäftigten, und Mitbegründer des kosmologischen Standardmodells, in dem kalte Dunkle Materie die wesentliche Materie-Komponente ausmacht und die Kosmologische Konstante (bzw. Dunkle Energie) die dominante Energieform darstellt [3]. Um die unerwartet kleine Amplitude der Temperaturschwankungen im Universum zu erklären, schlug Peebles 1982 vor, dass die kosmische Materie zum weitaus überwiegenden Teil aus nichtrelativistischen Teilchen bestehen könnte, die nicht mit Licht wechselwirken. Damit trat die kalte Dunkle Materie auf den Plan, ohne die das kosmologische Standardmodell erfolglos wäre. Der Titel seines ersten Buches „Physical Cosmology“ aus dem Jahr 1971 beschreibt den wesentlichen Beitrag von Peebles: Er machte aus der Kosmologie eine quantitative Wissenschaft. Zuvor war die Kosmologie oft etwas abwertend als die Wissenschaft der drei Zahlen bezeichnet worden: Hubble-Konstante H0, Brems- oder Beschleunigungsparameter q0 und Dichteparameter ρ0. Dieses Lehrbuch – wie auch „The Large-Scale Structure of the Universe“ von 1980 und die „Principles of Physical Cosmology“ von 1993 – waren schon zu ihrer Zeit Standardwerke, und sie gehören auch heute noch zum Repertoire jedes Studierenden der Extragalaktik und Kosmologie. Damit hat Peebles das Denken von Generationen von Studierenden und Wissenschaftlern geprägt. Er ist ein Wegbereiter der modernen Kosmologie...

Egbert Figgemeier und Moritz Teuber • 12/2019 • Seite 28

Egbert Figgemeier und Moritz Teuber • 12/2019 • Seite 28Bedeutsame Batterien

Lithium-Ionen-Batterien sind eine wissenschaftliche Meisterleistung und die Messlatte für zukünftige Batterietechnologien.

Die Entwicklung leistungsfähiger elektrochemischer Energiespeicher – sprich Batterien – ist ein entscheidender Baustein für das Entstehen einer vernetzten, mobilen und nachhaltigen Gesellschaft. Der diesjährige Chemie-Nobelpreis für Akira Yoshino, M. Stanley Whittingham und John B. Goodenough, die wesentlich zur Realisierung von Lithium-Ionen-Batterien beigetragen haben, würdigt die hohe Bedeutung dieser Technologie.

Die bahnbrechenden Arbeiten der diesjährigen Chemie-Nobelpreisträger und vieler weiterer Forscher über die letzten Jahrzehnte haben die Grundlagen für Batterien1) gelegt, ohne die Smartphones, Tablets oder batterie-elektrische Fahrzeuge in ihrer heutigen Form nicht denkbar wären [1]. Die Entwickler der Lithium-Ionen-Batterie haben damit unsere Gesellschaft nachhaltig verändert.

Leistungsfähige Batterien haben sich als ein strategisch wichtiger Baustein für die globale und nationale wirtschaftliche Entwicklung herausgestellt. Noch vor etwa zehn Jahren trieb hauptsächlich die Verbreitung tragbarer Elektronik und Kommunikation die Weiterentwicklung an. Diese wurde daher mit Nachdruck in Asien verfolgt, während das Thema in Europa stark vernachlässigt oder sogar belächelt wurde. Inzwischen besteht ein genereller gesellschaftlicher Konsens, welcher der Batterie eine zentrale Rolle in der Dekarbonisierung der Energieversorgung sowie in der lokal emissionsfreien Mobilität zuweist. Zudem sind Batterien dringend nötig, um zeitliche Inkompatibilitäten in der Sektorenkopplung zu puffern. Die zeitlich flexible Ladung und Entladung von Fahrzeugbatterien gemäß der Verfügbarkeit regenerativ erzeugter Energie ist ein Beispiel für die Kopplung der Sektoren „Energie“ und „Verkehr“. Dabei sind die Fahrzeuge selbst integraler Bestandteil einer dezentralen und schwankenden Energieerzeugung...

Kerstin Sonnabend • 2/2019 • Seite 24

Kerstin Sonnabend • 2/2019 • Seite 24"Do what you love and you will do your best"

Donna Strickland needed a high-intensity laser pulse for her PhD thesis studies and, therefore, she developed the chirped pulse amplification.

Donna Strickland needed a high-intensity laser pulse for her PhD thesis studies and, therefore, she developed the chirped pulse amplification.

The Nobel Prize in Physics 2018 was awarded “for groundbreaking inventions in the field of laser physics”. Arthur Ashkin shared one half “for the optical tweezers and their application to biological systems”. The other half went jointly to Gérard Mourou and Donna Strickland “for their method of generating high-intensity, ultra-short optical pulses”. Donna Strickland is the third woman to win a Nobel Prize in Physics. She was working on her PhD thesis in the group of Gérard Mourou when she performed the awarded research and she was the first author of the decisive paper.

Chirped pulse amplification was not the topic of your PhD thesis. Why did you work on it anyway?

I was the only person in the group that was working on a high-intensity laser project. I was supposed to measure the ninth harmonic of a YAG laser impinging on a nickel plasma. Therefore, I needed a short laser pulse with sufficient energy but pulse compression did not work.

Why not?

There was a number of reasons – one of them being self-focussing. Because the self-focussing length changes with the power not all of the pulse can focus to the same point in space. Gérard Mourou, my supervisor at the time, came up with the idea of the so-called chirped pulse amplification to overcome the problem. We scrapped what I was working on before and started with the new technique...

Georg Korn • 12/2018 • Seite 27

Georg Korn • 12/2018 • Seite 27Gestreckt zu Höchstleistungen

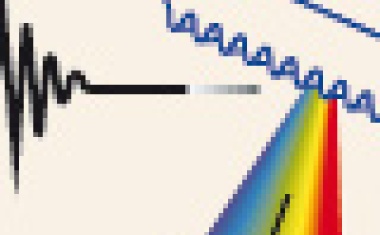

Eine Hälfte des Physik-Nobelpreises 2018 teilen sich Donna Strickland und Gérard Mourou für die Methode der Chirped Pulse Amplification.

Der erste experimentelle Beweis starker optischer Laserstrahlung gelang Theodore H. Maiman 1960 mit einem Rubinlaser. Basierend auf einer Reihe wichtiger experimenteller und theoretischer Arbeiten zu Lasern und Masern erhielten Charles H. Townes, Nikolai G. Bassow und Alexander M. Prochorow 1964 den Nobelpreis für Physik. Im laufenden Jahr teilen sich Donna T. Strickland und Gérard A. Mourou eine Hälfte des Preises für die Entwicklung einer Methode, um hochintensive und ultrakurze optische Pulse zu erzeugen.

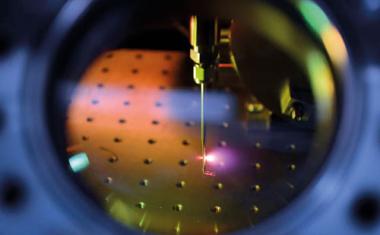

Noch in den 1960er-Jahren führten Verfahren wie die Gütemodulation (Q-switch) dazu, Laserpulse im Nanosekundenbereich zu erzeugen. In Kombination mit passiver und aktiver Modensynchronisation erhöhte sich bis zu den 1970er-Jahren die verfügbare Spitzenleistung von Laseroszillatoren wesentlich durch den Übergang in den Pikosekundenbereich – zunächst in den Kilowatt- und später in den Megawatt-Bereich. Parallel dazu wuchs das wissenschaftliche Interesse, bei gleicher Energie durch immer kürzere Pulse eine wesentlich höhere Spitzenleistung im Fokus des Lasers zu erreichen (Infokasten). Dazu eignen sich insbesondere Festkörperlaser aus Materialien, wie zum Beispiel Nd-dotierten Gläsern. Deren Fähigkeit, Energie zu speichern, führt durch die große Bandbreite des Laserübergangs zur Verstärkung kurzer energiereicher Pulse. Schon eine einfache Abschätzung beweist die hohe extrahierbare Spitzenleistung eines Nd:Glas-Lasers von etwa 10 TW/cm2. Bei diesen Intensitäten führt nichtlineare Selbstfokussierung dazu, dass die Eigenschaften der Laserstrahlung im Material verändert werden, was zu einer Verringerung der Fokussierbarkeit führt. Dabei induziert ein Laserstrahl durch Streuzentren Interferenzen mit sich selbst. Durch eine intensitätsabhängige Modulation des Brechungsindex wandeln sich die Interferenzen in Phasengitter um, die Teile des Laserlichts durch Diffraktion ablenken. Bei steigender Laserintensität dominiert dieser Prozess: Die Strahlung lässt sich nicht mehr fokussieren, und das Material wird zerstört. Um zu höheren Spitzenleistungen und Energien zu gelangen, galt es daher, diese nichtlinearen Effekte unter Kontrolle zu bringen.

Die einzige bekannte Methode bestand darin, den Strahldurchmesser zu vergrößern. Das kann durch Erhöhung der Apertur oder durch Parallelisierung von Strahlen erfolgen, wie zum Beispiel an der National Ignition Facility (NIF) in Livermore, Kalifornien. Die extrem gute zeitliche Synchronisation bei sehr kurzen Pulsen ist allerdings eine große Herausforderung...

Christoph F. Schmidt • 12/2018 • Seite 24

Christoph F. Schmidt • 12/2018 • Seite 24Fesselnde Laserstrahlen

Eine Hälfte des Physik-Nobelpreises 2018 geht an Arthur Ashkin für die Erfindung der optischen Pinzette und ihre Anwendung auf biologische Systeme.

Arthur Ashkin ist mit 96 Jahren der bisher älteste Empfänger des Nobelpreises. Seine geniale Entdeckung der optischen Pinzette beruht auf der Kraft, die Photonen bei der Wechselwirkung auf Materie ausüben. Eine geschickte Optik erlaubt es, diese Kraft so zu lenken, dass sich mikrometergroße kolloidale Partikel im Raum an einem Punkt ohne direkte Berührung festhalten lassen.

Im Jahr 1619 erklärte Johannes Kepler die Beobachtung, dass der Schweif von Kometen stets von der Sonne weg weist, mit dem Druck, den das Sonnenlicht auf die vom Kometen ausgestoßene Materie ausübt. Dies etablierte die Vorstellung, dass Licht eine Kraft ausüben kann. James Clerk Maxwell stellte Keplers Vermutung 1862 mithilfe seiner Theorie der elektromagnetischen Wellen auf eine solide Basis. Heute wissen wir, dass sich dieses Phänomen auch als Impulsübertrag abgelenkter oder reflektierter Photonen betrachten lässt. Die Kraft, die zum Beispiel das Sonnenlicht an einem schönen Sommertag auf einen Spaziergänger ausübt, ist allerdings unmerklich klein. So wird unser sonnenbestrahlter Kopf lediglich mit einigen 100 nN nach unten gedrückt – dies ist vergleichbar mit dem Bruchteil des Gewichts eines Haares!

Mit Sonnenlicht oder gewöhnlichen Lampen war der Strahlungsdruck des Lichts nur sehr schwer zu messen. Die Funktion der von William Crookes 1873 vorgestellten „Lichtmühle“– heute noch ein beliebtes Spielzeug – wird oft fälschlicherweise mit Strahlungsdruck erklärt. Sie beruht aber auf Photophorese, also differentiellem Gasdruck, der auf die schwarzen und silbernen Seiten der Flügel der im Teilvakuum gelagerten Mühle wirkt. Das zeigt sich auch daran, dass sich die Mühle unter Beleuchtung von den geschwärzten Seiten der Flügel weg dreht...

Jürgen Plitzko • 12/2017 • Seite 33

Jürgen Plitzko • 12/2017 • Seite 33Proteine in Eis

Der Chemie-Nobelpreis würdigt Entwicklungen der Kryo-Elektronenmikroskopiefür die Proteinstrukturanalyse.

Der Nobelpreis für Chemie geht zu gleichen Teilen an Joachim Frank, Jacques Dubochet und Richard Henderson für ihre Arbeiten zur Kryo-Elektronenmikroskopie an Biomolekülen in Lösung. Diese Methode erlaubt es, mit Transmissions-Elektronen-Mikroskopen (TEM) makromolekulare Komplexe und Proteine in wässriger Umgebung mit atomarer Auflösung abzubilden.

Die Chemie-Nobelpreisträger sind von Haus aus Physiker, die sich durch ihre Arbeit für ein biophysikalisches Verfahren verdient gemacht haben: Richard Henderson bewies, dass Hochauflösung an Biomolekülen möglich ist. Jacques Dubochet entwickelte eine Kryo-Präparationsmethode, mit der sich Biomoleküle tiefgefroren in wässriger Umgebung im Elektronenmikroskop untersuchen lassen. Joachim Frank leistete wichtige methodische Beiträge in der elektronenmikroskopischen Bildverarbeitung für die Einzelpartikelanalyse. Diese Pionierarbeiten liegen über 30 Jahre zurück. Seitdem hat sich die Strukturforschung mit dem Elektronenmikroskop weiterentwickelt. Der Durchbruch gelang vor etwa vier Jahren. Hier möchte ich die Hintergründe und Vorgeschichte dieser Erfolge auch aus persönlicher Perspektive beleuchten.

Die Strukturaufklärung von Biomolekülen ist eine klassische Domäne der über hundert Jahre alten Röntgen-Kristallographie. In den 1950er-Jahren war ihre Geburtsstunde mit der Aufklärung der Struktur der DNA sowie der von Haemoglobin und Myoglobin, die 1962 zu zwei Nobelpreisen führte. Weitere Nobelpreise mit Bezug zu den diesjährigen Preisträgern folgten, etwa 1988 für die Erforschung des Reaktionszentrums der Photosynthese oder 2009 für die Aufklärung der Ribosom-Struktur...

Hartmut Grote • 12/2017 • Seite 28

Hartmut Grote • 12/2017 • Seite 28Der lange Weg zum Nachweis

Der Nobelpreis für Physik 2017 würdigt den Nachweis von Gravitationswellen.

Der diesjährige Nobelpreis geht zur Hälfte an Rainer Weiss und zu jeweils einem Viertel an Kip Thorne und Barry Barish für ihre Beiträge zu den LIGO-Detektoren, mit denen es 2015 nach jahrzehntelangen Vorarbeiten erstmals gelang, Gravitationswellen direkt nachzuweisen.

1916 sagte Albert Einstein Gravitationswellen aus der Allgemeinen Relativitätstheorie voraus, war aber selbst skeptisch, ob man diese überhaupt jemals würde beobachten können. Über Jahrzehnte gab es zudem Kontroversen um ihre prinzipielle Messbarkeit, die erst Ende der 1950er-Jahre abnahmen. Zu dieser Zeit begann Joseph Weber in den USA die ersten Experimente mit dem Ziel, Gravitationswellen zu messen. Er nutzte massive Metallzylinder, die von den Wellen zu mechanischen Schwingungen angeregt werden sollten und war Ende der 60er-Jahre zunehmend überzeugt, dass ihm der Nachweis geglückt sei. Diese Entwicklung gab den Anstoß für Replikationsversuche, insbesondere in München, wo am Max-Planck-Institut für Astrophysik die Keimzelle der Gravitationswellenastronomie in Deutschland entstand. Heinz Billing und sein Mitarbeiter Walter Winkler bauten eine Resonanzantenne ähnlich zu Webers Detektoren. Die Münchner Gruppe analysierte ihre Daten in Koinzidenz mit einer Gruppe in Frascati (Italien), die einen Detektor ganz ähnlicher Bauweise konstruiert hatte. Es gab jedoch, wie auch bei anderen Replikationsversuchen danach, keinerlei Hinweise auf Gravitationswellen.

Obwohl sich die Meinung durchsetzte, dass Weber sich geirrt haben musste, so hatte er doch den entscheidenden Anstoß gegeben: Viele Forscher blieben dem Gebiet treu und wollten nun wirklich Gravitationswellen finden. Einige entwickelten die Technik der Zylinderantennen zu Meisterwerken kryogener Technik weiter [1], von denen zwei noch bis 2016 in Betrieb waren. Andere Forscher wandten sich der Laserinterferometrie zu, deren Messprinzip auf Albert Michelsons Schöpfung von 1881 zum Nachweis des hypothetischen Äthers beruht. Für die Detektion von Gravitationswellen sind jedoch um viele Größenordungen empfindlichere und größere Interferometer notwendig...

Ronny Thomale • 12/2016 • Seite 24

Ronny Thomale • 12/2016 • Seite 24Ihrer Zeit vorausgeeilt

Die Vordenker topologischer Phasen in Festkörpern erhalten den Nobelpreis für Physik 2016.

Den diesjährigen Nobelpreis für Physik erhalten David James Thouless, Frederick Duncan Michael Haldane und John Michael Kosterlitz für die Entdeckung topologischer Phasen und Phasenübergänge. Was zu der Zeit, als die drei Physiker ihre Theorien ausgearbeitet haben, in erster Linie ein mathematisches Konzept war hat heute in der Physik vielfältige und bedeutende Anwendungen. Die wahre Geburtsstunde topologischer Phasen in der Festkörperphysik war die Erklärung des Quanten-Hall-Effekts.

Der experimentelle Physiker hat etwas, er kann es auch beschreiben, aber er weiß nicht, was es ist. Der theoretische Physiker hat nichts, aber er kann es beschreiben und glaubt zu wissen, was es ist. Der mathematische Physiker hat nichts, er kann es nicht beschreiben, und er weiß nicht, was es ist.“ Dieses Zitat Werner Heisenbergs, dessen Trikolon in der nihilistischen Existenz des mathematischen Physikers gipfelt, wirft ein bemerkenswertes Licht auf die physikalische Forschungslandschaft der Neuzeit. Ungleich faszinierender als das etablierte Spannungsfeld zwischen mathematischer Abstraktion und epistemologischer Beobachtung erscheint hierbei, wie Heisenberg den theoretischen Physiker charakterisiert. Er ist der Einzige, dessen Rezeption der Natur an das Wesen des Forschungsgegenstands heranreicht.

Betrachtet man die Nobelpreise in der Festkörperphysik der vergangenen Jahrzehnte, so fällt auf, dass das Nobelkomitee vornehmlich experimentelle Entdeckungen mit weitreichenden technologischen Implikationen sowie deren konkrete theoretische Vorhersage bedacht hat. In dieser Hinsicht ist die Verleihung des Nobelpreises für Physik 2016 an David James Thouless, Frederick Duncan Michael Haldane und John Michael Kosterlitz (Abb. 1) eine große Besonderheit: Alle drei sind ihres Zeichens ausgewiesene theoretische Physiker im Heisenbergschen Sinn. Dennoch haben sie vorrangig weniger eine singuläre Entdeckung gemacht, sondern vielmehr eine Sprache vorgedacht, mit der die Physik hofft, fundamentale Entdeckungen und technologische Revolutionen feiern zu können. Der diesjährige Nobelpreis für Physik prämiert in gewisser Weise eine Vision der Festkörpertheorie und ist damit genauso seiner Zeit voraus wie die Preisträger in ihren bahnbrechenden Werken...

Guido Drexlin, Manfred Lindner und Christian Weinheimer • 12/2015 • Seite 24

Guido Drexlin, Manfred Lindner und Christian Weinheimer • 12/2015 • Seite 24Wandelbare Geisterteilchen

Für ihre Arbeiten zu Neutrinooszillationen erhalten Takaaki Kajita und Arthur B. McDonald

den Physik-Nobelpreis 2015.

Mit Hilfe langwieriger und herausfordernder Messungen mit den beiden Experimenten SNO und Super-Kamiokande ließen sich die über viele Jahre bestehenden Probleme der „fehlenden“ Sonnen- und Atmosphärenneutrinos lösen. Dadurch gelang es, die Hypothese zu bestätigen, dass sich Neutrinos im Flug von einer Sorte in eine andere umwandeln. Als Leiter der Kollaborationen haben die beiden diesjährigen Nobelpreisträger damit die Tür zur weiteren Erforschung der Eigenschaften dieser faszinierenden Teilchen weit aufgestoßen.

Der diesjährige Physik-Nobelpreis ehrt einen der wichtigsten experimentellen Durchbrüche der Physik in den letzten Jahrzehnten. Der erstmalige experimentelle Nachweis der Oszillation von atmosphärischen Neutrinos mit dem Super-Kamiokande-Detektor in Japan und der Nachweis von Flavour-Übergängen von solaren Neutrinos mit dem Sudbury Neutrino Observatory (SNO) in Kanada zeigten um die Jahrtausendwende, dass Neutrinos entgegen den Annahmen des Standardmodells der Teilchenphysik eine von Null verschiedene Masse besitzen.

In den Neunzigerjahren gab es zwei große Rätsel im Zusammenhang mit Neutrinos. Zum einen „fehlten“ Sonnenneutrinos: Eine Vielzahl an Experimenten (Homestake, GALLEX/GNO, SAGE, Kamiokande) stellte ein signifikantes Defizit an Elektronneutrinos aus der Sonne fest. Die Anzahl der Elektronneutrinos, die bei den Kernfusionsreaktionen von Wasserstoff zu Helium im Sonneninnern entstehen, lässt sich gut vorhersagen, sodass entweder neue Astrophysik oder neue Neutrino-Eigenschaften zur Lösung des Rätsels notwendig waren. Zum anderen fanden sich zu wenige atmosphärische Myonneutrinos: Trifft kosmische Strahlung die obere Atmosphäre, entstehen durch Zerfälle von Pionen und Myonen Neutrinos. Das Flavour-Verhältnis von Myon- zu Elektronneutrinos sollte dabei 2:1 betragen. Analysen großvolumiger Wasser-Cherenkov-Detektoren (Kamiokande, IMB) wichen aber mit einem Verhältnis von fast 1:1 deutlich davon ab.

In beiden Fällen wurde frühzeitig das Phänomen der Neutrinooszillation als mögliche Ursache in Betracht gezogen. Am besten zeigt sich dies bei der Untersuchung von atmosphärischen Neutrinos. Hierbei übernahm das Kamiokande-Experiment eine Pionierrolle. Die schon damals von Takaaki Kajita mitgestalteten Analysen zeigten ein überraschendes Defizit von unten kommender Myonneutrinos, trotz eines symmetrisch aufgebauten Detektors [1]. ...

Alexander Pawlak • 6/2015 • Seite 23

Alexander Pawlak • 6/2015 • Seite 23„Ich wollte es den Zweiflern zeigen“

Interview mit dem Chemie-Nobelpreisträger Stefan W. Hell

Seit fast dreißig Jahren beschäftigt sich Stefan W. Hell (52) mit Mikroskopie. Schon sehr früh setzte er sich zum Ziel, eine Methode zu entwickeln, mit der sich die Beugungsgrenze durchbrechen lässt. Dieses verfolgte er hartnäckig weiter und nahm dafür eine wechselvolle akademische Karriere in Kauf, die ihn schließlich ans Max-Planck-Institut für biophysikalische Chemie in Göttingen führte, wo er seit 2002 Direktor ist. 2014 erhielt er gemeinsam mit Eric Betzig und William E. Moerner den Chemie-Nobelpreis für die Entwicklung superauflösender Fluoreszenzmikroskopie.

Woher kam die Idee, sich mit der Auflösungsgrenze zu beschäftigen?

Zur Mikroskopie bin ich über meine Doktorarbeit über Konfokalmikroskopie bei Siegfried Hunklinger in Heidelberg gekommen. An sich hatte ich das Gefühl, dass das Thema Lichtmikroskopie ausgereizt ist, andererseits wollte ich etwas fundamental Neues machen. In diesem Spannungsfeld habe ich angefangen, herum zu überlegen und war rasch davon überzeugt: Da muss doch was drin sein!

Woher kam die Gewissheit?

Aus dem breiten Wissen der Physik, das ich mir im Studium aufgebaut habe. Während der Promotion hatte ich die Intuition entwickelt, dass sich doch irgendeins der vielen Phänomene, welche die Physik im 20. Jahrhundert gefunden hat, einsetzen lassen müsste, um die Beugungsgrenze im Lichtmikroskop zu knacken...

Jörg Bewersdorf, Christian Eggeling und Thomas A. Klar • 12/2014 • Seite 23

Jörg Bewersdorf, Christian Eggeling und Thomas A. Klar • 12/2014 • Seite 23Abbe ausgetrickst

Für ihre Arbeiten zur super-auflösenden Fluoreszenzmikroskopie erhalten Stefan W. Hell, Eric Betzig und William E. Moerner den Chemie-Nobelpreis 2014.

Durch kein Mikroskop können Theile getrennt (...) werden, wenn dieselben einander so nahe stehen, dass auch der erste durch Beugung erzeugte Lichtbüschel nicht mehr gleichzeitig mit dem ungebeugten Lichtkegel in das Objectiv eintreten kann“ schrieb Ernst Abbe im Jahre 1873 in seinem denkwürdigen Aufsatz „Beiträge zur Theorie des Mikroskops und der mikroskopischen Wahrnehmung“ [1]. Eine Seite weiter kommt er zu der Formel, die wir alle im Grundstudium der Physik gelernt haben, dass nämlich die laterale Auflösung durch ein Drittel der Wellenlänge gegeben ist, für sichtbares Licht also etwa 200 nm beträgt. Den diesjährigen Nobelpreis für Chemie erhalten Stefan W. Hell, William E. Moerner und Eric Betzig dafür, dass sie Methoden entwickelt haben, um dieses Beugungslimit zu brechen.

Doch zunächst zur Historie. Nicht nur Ernst Abbe, sondern auch Lord Rayleigh und C. Sparrow argumentierten, dass die Wellennatur des Lichts und die daraus resultierenden Beugungserscheinungen die Auflösung im Mikroskop beschränken und unweigerlich dazu führen, dass sich Licht nicht besser fokussieren lässt als auf ein diffuses Beugungsscheibchen mit einem lateralen Durchmesser von etwa 200 nm. Dieses „Naturgesetz“ wurde seit dem Ende des 19. Jahrhunderts jedem und jeder Studierenden der Physik beigebracht und als unumstößliche Grenze der Auflösung vermittelt. Wie so oft, wenn eine vermeintliche Tatsache nur häufig genug wiederholt wird, wird sie zum Dogma, das kaum jemand infrage stellt. Und das, obwohl alle „Zutaten“ für die Überwindung dieser Auflösungsgrenze eigentlich schon Ende der 1920er-Jahre vorhanden gewesen wären: Die Tatsache, dass Farbstoffmoleküle gegenüber ihrer Emissionswellenlänge blauverschoben absorbieren, hatte Sir Stokes im Jahr 1852 empirisch beschrieben. Richtig spannend wurde es aber mit der Quantenchemie: Niels Bohr stellte 1913 die Quantentheorie der Absorption und Emission von Licht durch Atome auf, und 1927 dehnten Born und Oppenheimer (neben anderen) diese Theorie auf Moleküle aus. 1916 postulierte Einstein die Existenz der stimulierten Emission, die Kopfermann und Ladenburg 1928 experimentell verifizieren konnten. Obwohl all dies bekannt war, dauerte es 66 Jahre, bis Stefan Hell als junger Nachwuchswissenschaftler nicht von der Idee lassen wollte, dass – bei all dem, was die moderne Physik zu bieten hat – ein Beugungslimit von 1873 nicht der Weisheit letzter Schluss sein konnte. ...

Henning Riechert • 12/2014 • Seite 28

Henning Riechert • 12/2014 • Seite 28Ein blaues Wunder

Für die Entwicklung der blauen Leuchtdiode erhalten Isamu Akasaki, Hiroshi Amano

und Shuji Nakamura den Physik-Nobelpreis 2014.

Blaue Leuchtdioden waren bis Mitte der Neunzigerjahre exotische Bauelemente. Das einzige dafür verfügbare Festkörper-Material, Siliziumkarbid (SiC), war wegen seiner indirekten Band-lücke eigentlich ungeeignet. Daher blieben die blauen Leuchtdioden (LED) lichtschwach und ineffizient. Immerhin fanden sie sich als Fernlicht-Indikator in jedem Auto, waren anderweitig aber kaum nutzbar. Neue Hoffnung hatte der III-V-Verbindungshalbleiter Galliumnitrid (GaN) versprochen, der schon länger in der Forschung bekannt war.

Bereits in den Siebzigerjahren hatte es größere internationale Anstrengungen gegeben, GaN technologisch zu beherrschen. Damals ließen sich viele seiner grundlegenden Eigenschaften bestimmen. Zudem fand man heraus, dass sich GaN wegen seiner direkten Bandlücke sehr gut zur Lichterzeugung eignen sollte. An seiner technischen Beherrschung bissen sich jedoch alle Forscher die Zähne aus – fortan sah alles danach aus, dass GaN nur eine kurze Episode in der Geschichte der Optoelektronik bleiben würde.

Die stürmische Entwicklung dieses Gebietes hatte Anfang der Sechzigerjahre eingesetzt, als es gelungen war, Galliumarsenid (GaAs) und verwandte Halbleiter erfolgreich herzustellen. Technologen und Forscher hatten gelernt, Einkristalle aus GaAs oder Indiumphosphid (InP) zu ziehen, Substrate daraus herzustellen und n- sowie p-dotierte dünne kristalline Schichten von hoher Qualität (epitaktisch) darauf abzuscheiden. Erste Leuchtdioden und Halbleiterlaser entstanden, und rasch entwickelte sich daraus die optische Nachrichtentechnik mit Datenübertragung über Glasfasern. Im Zuge dieser Entwicklung gerieten LEDs etwas aus dem Fokus – Laser und die darin verwendeten Quantenstrukturen waren einfach mehr „sexy“. Dazu kam, dass die verfügbaren Materialien mit direkter Bandlücke nur den Spektralbereich vom nahen Infrarot bis zum Roten abdeckten. Daher war gar nicht daran zu denken, die drei Grundfarben Rot, Grün und Blau mit effizienten LEDs zu erzeugen – und damit auch weißes Licht. ...

Stefan Jorda • 5/2014 • Seite 22

Stefan Jorda • 5/2014 • Seite 22„Nicht der kostengünstigste Weg“

Interview mit dem Physik-Nobelpreisträger und ehemaligen amerikanischen

Energieminister Steven Chu zur Energiefrage

Als Wissenschaftler entwickelte er bei den Bell Labs und an der Stanford University Methoden, um Atome zu kühlen und zu speichern. Dafür erhielt Steven Chu 1997 den Physik-Nobelpreis. Als Manager leitete er fünf Jahre lang das Lawrence Berkeley National Lab, bevor er 2009 dem Ruf von Barack Obama folgte und Energieminister wurde. Inzwischen ist er als Professor für Physik und Physiologie wieder zurück an der Stanford University, engagiert sich aber unverändert in Sachen Klimawandel und Energiepolitik. Sein Plenarvortrag „Meeting the Energy Challenge“ bei der DPG-Jahrestagung in Berlin gab die Gelegenheit zum folgenden Interview.

Die bekannten Öl- und Gasreserven wachsen weiter. Sind die damit einhergehenden niedrigen Preise nicht kontraproduktiv für das Ziel, die Emissionen zu reduzieren?

Ein Barrel Öl kostet etwa 100 Dollar, das ist nicht so wenig. Aber unsere Fähigkeit, Öl zu diesem Preis zu finden und zu extrahieren, nimmt tatsächlich zu, und der Ölpreis könnte noch einige Dekaden bei 100 Dollar bleiben. Bei 70 Prozent der Ölreserven handelt es sich um Ölschiefer oder Ölsand.

Bedeutet dies, dass der Druck nachlässt, auf erneuerbare Energien umzustellen?

Das Zeitalter des Öls wird nicht zu Ende gehen, weil es kein Öl mehr gibt. Genauso wenig ist die Steinzeit aus Mangel an Steinen zu Ende gegangen, sondern weil es bessere Lösungen gab. Wir müssen wegen des Klimawandels von den fossilen Energiequellen weg kommen. Die Risiken wären gewaltig, wenn wir die vorhandenen Reserven nur annähernd aufbrauchen würden. ...

Tilman Plehn und Michael Krämer • 12/2013 • Seite 24

Tilman Plehn und Michael Krämer • 12/2013 • Seite 24Das Higgs-Teilchen und seine Väter

Für die Entdeckung eines Mechanismus‘ zur Massenerzeugung erhalten François Englert und Peter Higgs den Physik-Nobelpreis 2013.

Die Entdeckung des Higgs-Teilchens ist der bisherige Höhepunkt des vielleicht größten und langfristigsten Projekts der Grundlagenforschung. Es begann mit Enrico Fermi und seinem „Versuch einer Theorie der β-Strahlen“ 1934. Als großes strukturelles Problem dieser Theorie der schwachen Kernkraft stellte sich im Laufe der Jahrzehnte die Tatsache heraus, dass die nach ihm benannte Fermi-Kopplungskonstante nicht einfach eine Zahl ist, sondern die Einheit von 1/Masse2 hat.

Ein Jahr später stellte Hideki Yukawa die grundlegende Verbindung dieses Problems mit dem Higgs-Mechanismus und der Masse von Teilchen her mit seiner Arbeit „On the interaction of elementary particles“: Die schwache Kernkraft hat nur eine kurze Reichweite, die sich mit Hilfe von massiven Austauschteilchen erklären lässt, die wiederum für eine Kopplungskonstante mit Einheit 1/Masse2 verantwortlich sind. In diesem Sinne ist der Higgs-Mechanismus nicht in erster Linie für die Masse zum Beispiel des Tisches, auf dem dieser Artikel geschrieben wird, verantwortlich, sondern für die Größe von Atomkernen.

Mit masselosen Austauschteilchen beschäftigten sich seit den 1920er-Jahren viele Physiker. 1942 schlug Sin-Itiro Tomonaga eine mathematisch umfassend verstandene Quantentheorie der elektrischen Ladung, die Quantenelektrodynamik, vor. Unabhängig davon entwickelte Julian Schwinger 1948 dieselbe Theorie. Sowohl Fermis Theorie als auch die Quantenelektrodynamik waren experimentell außerordentlich erfolgreich, und aus heutiger Sicht war die offensichtliche Frage lediglich, wie man eine Version der Quantenelektrodynamik mit massiven Austauschteilchen konstruieren kann, um aus Fermis Theorie der schwachen Kermkräfte eine moderne Quantentheorie zu machen. Tatsächlich versuchte sich Sheldon Glashow, ein Student von Schwinger, im Jahr 1961 noch ohne durchschlagenden Erfolg an diesem Problem.

Zu diesem Zeitpunkt betreten Peter Higgs, Robert Brout und François Englert die Bühne. Die grundlegende Idee hinter dem Higgs-Mechanismus oder allgemeiner der sog. spontanen Symmetriebrechung ist sehr einfach: Wenn man zum Beispiel die Energieniveaus im Wasserstoffatom betrachtet, dann gibt es viele verschiedene Elektronenzustände mit identischen Energien, weil das Atom unter Rotationen im Raum symmetrisch ist. Bricht man diese Symmetrie von außen, zum Beispiel mit Hilfe eines starken Magnetfelds, so spalten diese Energieniveaus auf. Bei der spontanen Symmetriebrechung hingegen bricht in einem physikalischen System nicht eine bestimmte Wechselwirkung die Symmetrie; das System nimmt aus welchem Grund auch immer einen Zustand an, der eben nicht symmetrisch ist. Der Higgs-Mechanismus geht noch einen Schritt weiter, indem er postuliert, dass das ganze Universum in einem nicht symmetrischen Vakuum-Zustand existiert, von dem wir aber nicht wissen, wie und warum dieser zustande gekommen ist. Wenn eine symmetrische Welt nur masselose Teilchen erlaubt, dann haben diese Teilchen in einer gebrochen symmetrischen Welt Massen. Kurz nach dem Urknall mag das Vakuum noch symmetrisch gewesen sein, aber heute sehen wir nur eine reduzierte Symmetriestruktur mit massiven Austauschteilchen der schwachen Kernkraft. ...

Stefan Jorda • 3/2013 • Seite 26

Stefan Jorda • 3/2013 • Seite 26Ein Weltbürger der Wissenschaft

Am 9. März wird der in Wien geborene Physiker und Chemie-Nobelpreisträger Walter Kohn 90 Jahre alt.

Kindheit in Wien, Vertreibung durch die Nazis, Studium und Promotion in Toronto und Harvard, später Professuren in San Diego und Santa Barbara – das sind einige Stationen des bewegten Lebens von Walter Kohn, der Mitte der 1960er-Jahre die Dichtefunktionaltheorie entwickelte, für die er 1998 den Nobelpreis für Chemie erhielt. Zu seinen vielen Ehrungen und Auszeichnungen zählt seit Dezember 2012 auch die Ehrendoktorwürde der Universität Wien.

Anfang 1938 ist für Walter Kohn die Welt noch in Ordnung: Der 14-jährige Sohn jüdischer Eltern besucht das Akademische Gymnasium in Wien, Latein ist sein Lieblingsfach. Mit dem Anschluss Österreichs an Nazideutschland im März 1938 ändert sich sein Leben aber radikal: Seine Familie, die den „Postkartenverlag Brüder Kohn“ betreibt, wird enteignet, und der junge Walter muss das Gymnasium verlassen. Ab dem Herbst kann er als einer von wenigen die Schulausbildung am jüdischen Chajes-Gymnasium fortsetzen. Als nach und nach immer mehr Lehrer verschwinden, beginnt der Direktor und Physiker Emil Nohel selbst zu unterrichten und hinterlässt bleibenden Eindruck: „Als ich diesen Herrn gehört habe, sind mir alle möglichen Lichter aufgegangen“, erinnert sich Kohn, „das war der Anfang meines Interesses für die Physik“. Ein Jahr später, drei Wochen vor dem Beginn des Zweiten Weltkriegs, verlässt der 16-Jährige Wien mit einem Kindertransport Richtung England – seine Eltern sieht er nie wieder, sie werden deportiert und ermordet.

Als Angehöriger einer feindlichen Nation („enemy alien“) internieren die Briten Kohn im Frühjahr 1940 und schicken ihn im Sommer in ein kanadisches Lager. Dort organisieren internierte Wissenschaftler Unterricht, außerdem arbeitet Kohn als Holzfäller und spart den Lohn von 20 Cent am Tag, um ein Mathematik- und ein Physikbuch zu kaufen. Nachdem Scotland Yard bestätigt hat, dass er kein feindlicher Spion ist, kommt Kohn im Januar 1942 frei und studiert in Toronto Mathematik und Physik. Im letzten Kriegsjahr dient er in der kanadischen Armee und schreibt in der Freizeit seine erste Veröffentlichung über die Kreiselbewegung. Nach dem Krieg kann Kohn dank eines Stipendiums nach Harvard gehen, wo ihn Julian Schwinger als Doktorand annimmt. Im Jahr 1948 schließt er seine Dissertation über das quantenmechanische Dreikörperproblem ab – trotz aller kriegsbedingten Wirren im Alter von 25 Jahren. ...

Ferdinand Schmidt-Kaler und Dietrich Leibfried • 12/2012 • Seite 24

Ferdinand Schmidt-Kaler und Dietrich Leibfried • 12/2012 • Seite 24Zauberer im Quantenreich

Für ihre grundlegenden Experimente zu einzelnen Quantensystemen erhalten Serge Haroche

und David Wineland den Physik-Nobelpreis 2012.

It is fair to state that we are not experimenting with single particles, any more than we can raise Ichthyosauria in the zoo – diese Worte von Erwin Schrödinger stammen aus dem Jahr 1952. Sechzig Jahre später erhalten David Wineland vom National Institute of Standards and Technology (NIST) in Boulder, Colorado, USA, und Serge Haroche von der École Normal Supérieure (ENS) in Paris den Nobelpreis für ihre bahnbrechenden Experimente mit einzelnen Quantenteilchen. Eine theoretische Beschreibung dieser Experimente ist nicht schwer: Es genügt, Zwei-Niveau-Systeme, harmonische Oszillatoren und ihre Kopplung aneinander zu verstehen, also ausschließlich Bestandteile einer Anfängervorlesung in Quantenmechanik (Infokasten). Diese trügerisch simplen Elemente in einem Labor sauber herauszudestillieren und ihre Botschaften auf leicht ablesbaren Geräten anzuzeigen, erfordert dagegen einen Grad von Experimentierkunst, den Schrödinger schlicht für unmöglich gehalten hat. Aber genau das ist gelungen. Dave Wineland und Serge Haroche haben dazu entscheidend beigetragen.

Unweit des wunderschönen Jardin du Luxembourg und des Pantheon liegt in Paris ein Zentrum der französischen Physik, das Laboratoire Kastler-Brossel der ENS. Hier hat in der Tradition der Nobelpreisträger Alfred Kastler (1966) und Claude Cohen-Tannoudji (1997) auch Serge Haroche seine Experimente durchgeführt. Im Zentrum der bahnbrechenden Arbeiten aller dieser Forscher steht die Wechselwirkung von Licht mit Atomen. Aber erst Haroche ist es gelungen, die „experimentellen Methoden so weit zu entwickeln, um Quantensysteme zu manipulieren“, wie es in der Laudatio des Nobelkomitees heißt.

Serge Haroche wurde 1944 in Casablanca geboren und studierte in Paris an der ENS, die – ganz anders als die direkte Übersetzung ins Deutsche vermuten lässt – nach einem streng auf Leistung ausgelegten hochselektiven Auswahlverfahren nur die allerbesten Studierenden aufnimmt. Dort finden sie dann hervorragende Studienbedingungen vor. Haroche wurde 1971 in Paris promoviert, der Betreuer der Doktorarbeit war Claude Cohen-Tannoudji. ...

Maike Pfalz • 9/2012 • Seite 25

Maike Pfalz • 9/2012 • Seite 25Reif für die Insel

Seit 1951 tagen jedes Jahr Nobelpreisträger gemeinsam mit Nachwuchswissenschaftlern in Lindau am Bodensee. Dieses Jahr stand das Treffen wieder im Zeichen der Physik.

Schon bevor man über die Seebrücke hinüber in die Altstadt von Lindau auf die Insel fährt, lächeln einem zahlreiche Nobelpreisträger entgegen. Wenige hundert Meter weiter reihen sich vor der Inselhalle Luxuskarossen aneinander:

Porsche, VW und Audi haben ihre neuesten Modelle zur Verfügung gestellt, damit die schick gekleideten Chauffeure die Preisträger auf der Insel stilvoll von einem Punkt zum nächsten kutschieren können. In den Straßen prägen die Teilnehmer der Tagung das Bild: Wohin man auch blickt, überall sind junge Menschen aus aller Welt unterwegs, um ihren Hals baumeln die grauen Schlüsselbänder mit ihrem Teilnehmerausweis, über ihren Schultern hängt die glänzende Lindau-Bag. Ganz klar: An diesen paar Tagen ist auf der kleinen Insel nichts so wie den Rest des Jahres.

Die Insel Lindau hat eine Fläche von nur 68 Hektar und rund 3000 Einwohner, doch jedes Jahr im Frühsommer gesellen sich für eine Woche knapp 1000 Gäste hinzu – nämlich wenn die alljährliche Tagung der Nobelpreisträger ansteht. Die Idee dazu hatten zwei Lindauer Ärzte, die sich 1950 mit dem Wunsch nach einer wissenschaftlichen Tagung an Graf Lennart Bernadotte wandten, um die durch den Nationalsozialismus entstandene Isolation der deutschen Wissenschaft zu überwinden. Würden Nobelpreisträger an der Tagung teilnehmen, so fänden auch andere hochkarätige Wissenschaftler den Weg nach Deutschland, waren die beiden überzeugt – und sie sollten Recht behalten. So nutzte Graf Bernadotte seine Familienbande nach Stockholm und zum Nobelpreis-Komitee, um 1951 die Lindauer Nobelpreisträger-Tagung ins Leben zu rufen. Bis heute ist diese eng mit der Familie Bernadotte verknüpft. ...

Michael Engel, Johannes Roth und Hans-Rainer Trebin • 12/2011 • Seite 31

Michael Engel, Johannes Roth und Hans-Rainer Trebin • 12/2011 • Seite 31Eine unmögliche Entdeckung

Für die Entdeckung der Quasikristalle erhält Daniel Shechtman den Chemie-Nobelpreis 2011.

Traditionell teilen sich Festkörper in zwei Klassen auf: Kristalle und amorphe Phasen. Sie unterscheiden sich durch die Existenz (bzw. das Fehlen) einer atomaren Fernordnung. Seit den Arbeiten von René Just Haüy im 18. Jahrhundert ist bekannt, dass ein periodischer Aufbau die äußere Form von Kristallen erklären kann. Zur Beschreibung genügt eine von drei Vektoren aufgespannte Einheitszelle, die eindeutig mit Atomen belegt („dekoriert“) ist und sich nach den drei Raumrichtungen wiederholt, wie eine in die dritte Dimension erweiterte Tapete. Röntgenstrahlen oder Elektronen streuen an Kristallen um Wellenvektoren aus dem reziproken Gitter, das aus Summen und Differenzen einer Gitterbasis von drei Vektoren besteht.

In den 1970er-Jahren wurde heftig diskutiert, welche Abweichungen von periodischen Festkörperstrukturen möglich sind. Da gab es zunächst die inkommensurabel modulierten Kristalle, bei denen die Atome wie in einer eingefrorenen Schallwelle sinusförmig ausgelenkt sind. Die Wellenlänge der Modulation und die Gitterkonstante des Ausgangskristalls stehen in einem irrationalen Verhältnis, sodass es kein gemeinsames Vielfaches gibt und eine aperiodische Gesamtstruktur entsteht. Im reziproken Raum tritt zur Gitterbasis des Ausgangskristalls der Wellenvektor der Modulation hinzu, d. h. alle Reflexe sind jetzt Summen und Differenzen von vier Vektoren – ein als „quasiperiodisch“ bezeichneter Zustand. Indem der Modulationsvektor eine eigene Dimension erhielt, entstand ein vierdimensionaler periodischer Kristall, zunächst im reziproken, dann durch Fourier-Transformation im direkten Raum. Aus letzterem geht der inkommensurable Kristall durch Schnitt mit einer dreidimensionalen Hyperebene, dem physikalischen Raum, hervor. Dies war die Geburtsstunde der höherdimensionalen Kristallographie für aperiodische Systeme. ...

Bruno Leibundgut • 12/2011 • Seite 27

Bruno Leibundgut • 12/2011 • Seite 27Eins-a-Vermessung des Universums

Für die Entdeckung der beschleunigten Expansion des Universums erhalten Saul Perlmutter,

Brian P. Schmidt und Adam G. Riess den Nobelpreis für Physik 2011.

Walter Baade und Fritz Zwicky, ein deutscher und ein schweizer Astrophysiker, die in Kalifornien forschten, prägten 1934 den Begriff „Supernova“ für gigantische Sternexplosionen. Diese erstrahlen so hell, dass sie über weite Bereiche des Universums zu beobachten sind. Baade und Zwicky identifizierten zwei Hauptgruppen von Supernovae – solche mit Wasserstofflinien in ihren Spektren (als Typ II bezeichnet) und solche ohne Wasserstoff (Typ I) – und schlugen bereits vor, dass sich mithilfe von Supernovae kosmologische Entfernungen bestimmen lassen.

Anfang der 1980er-Jahre griff vor allem Andreas Tamman diese Idee wieder auf und zeigte, dass sich dafür vor allem Supernovae vom Typ Ia eignen. Bei dieser wichtigen Unterkategorie handelt es sich um thermonukleare Explosionen von Weißen Zwergen, erloschenen Sternen mit etwa 1,4 Sonnenmassen, die kurzzeitig sogar eine ganze Galaxie überstrahlen können. Im Verlauf der Explosion ändert sich die Helligkeit der Supernovae natürlich sehr stark und innerhalb weniger Tage. Der Helligkeitsverlauf ist aber relativ homogen, sodass die Hoffnung bestand, dass sie immer dieselbe Leuchtkraft am Maximum ihrer Lichtkurve erreichen würden. Damit würden sich Entfernungen einfach aus der beobachteten Helligkeit ableiten. Diese Hoffnung zerschlug sich 1991 gründlich, als einige Typ-Ia-Supernovae mit sehr unterschiedlichen Leuchtkräften beobachtet wurden. Zwei Jahre später zeigte allerdings Mark Phillips, dass sich die Form der Lichtkurve eignet, um die Leuchtkraft zu normieren. Seitdem gelten Typ-Ia-Supernovae als beste kosmische „Zollstöcke“.

Zu dieser Zeit bestand die Hauptaufgabe der beobachtenden Kosmologie darin, den Wert der momentanen Expansionsrate des Universums und der Abbremsung aufgrund der Gravitationsanziehung der Materie zu bestimmen. Die Expansionsrate, also die Hubble-Konstante, muss im nahen Universum gemessen werden. Aufgrund der Abbremsung hat sich diese „Konstante“ als Funktion der Zeit verändert, man spricht daher vom Hubble-Parameter. In der Vergangenheit hatte er einen größeren Wert als heute. Diese Abbremsung lässt sich nur über große Distanzen messen. ...

Stefan Jorda • 7/2011 • Seite 21

Stefan Jorda • 7/2011 • Seite 21''Das ist meine Kultur''

Interview mit dem Physik-Nobelpreisträger Jack Steinberger, der am 25. Mai seinen 90. Geburtstag feiern konnte.

Jack Steinberger wurde 1921 als Hans Jakob in Bad Kissingen geboren. Als 13-jährigen brachten ihn seine Eltern (gemeinsam mit seinem älteren Bruder) 1934 vor den Nazis in Sicherheit. In den USA studierte er bei Enrico Fermi, machte Karriere als Teilchenphysiker und entdeckte 1962 das Myon-Neutrino, wofür er 1988 gemeinsam mit Leon Lederman und Melvin Schwartz den Physik-Nobelpreis erhielt. In den Jahren danach lebte die Verbindung zu Bad Kissingen wieder auf, wo Jack Steinberger heute Ehrenbürger ist und seine ehemalige Schule seinen Namen trägt.

Welche Kindheitserinnerungen haben Sie noch an Deutschland?

Noch bevor der Hitler an die Macht kam, haben die Braunhemden Paraden gemacht in der Stadt mit torch lights, wie heißt das auf Deutsch?

Fackeln …

Ja, Fackelzüge. Dabei haben sie gesungen: „Wenn das Judenblut vom Messer spritzt, dann geht’s nochmal so gut.“ Das habe ich als Kind anhören müssen, der Antisemitismus war völlig öffentlich. Aber ich habe persönlich in der Schule keine Schwierigkeiten gehabt, und ich glaube, dass der Schulleiter alles getan hat, damit die jüdischen Kinder so lange es ging in der Schule bleiben konnten.

Sie haben in den USA studiert und sind über Umwege zur Physik gekommen.

Zunächst war ich Chemiker. Zur Physik bin ich im Krieg gekommen, weil man Physiker für die Entwicklung des Radars gebraucht hat.

Welcher Ihrer akademischen Lehrer hat Sie besonders beeindruckt?

Der erste Physiker, der mir sehr viel gegeben hat, ist kürzlich mit über 100 Jahren gestorben. Er hieß Laszlo Tisza, ein Ungar, der am MIT in Cambridge arbeitete. Nach dem Krieg hatte ich das enorme Glück, in Chicago weiter studieren zu können. Dort hatte ich einige wunderbare Lehrer. Einer war Fermi, bei dem ich meine Doktorarbeit machen konnte. Gregor Wenzel war ein weiterer Lehrer und Freund, auch mit Edward Teller habe ich ein bisserl studiert. Was er dann mit Atomwaffen gemacht hat, ist mir nicht sehr lieb. Sehr wichtig ist auch, dass ich ganz außergewöhnliche Mitschüler hatte. Einer war der Chinese Chen Ning Yang, ein anderer Marshall Rosenbluth, kennen Sie ihn? ...

Patrik Recher und Björn Trauzettel • 12/2010 • Seite 22Mit Tesafilm nach Stockholm

Für ihre bahnbrechenden Pionierarbeiten zu Graphen erhalten Andre Geim und Konstantin Novoselov den Nobelpreis für Physik 2010.

Stefan Jorda • 7/2010 • Seite 49''Ich versuche, mit intuitiven Bildern zu arbeiten''

Interview mit dem Pionier der Laserspektroskopie Theodor W. Hänsch

Hans-Georg Unger • 12/2009 • Seite 24Vater der Glasfaserkommunikation

Charles Kuen Kao erhält den Physik-Nobelpreis 2009 für seine bahnbrechenden Leistungen zur Lichtübertragung in Glasfasern.

Hans-Joachim Queisser • 12/2009 • Seite 27Eine entscheidende Stunde

Für die Entwicklung des Charge-Coupled Device (CCD) erhalten Willard S. Boyle und George E. Smith den Physik-Nobelpreis 2009.

Chris Quigg und Bruce D. Winstein • 12/2008 • Seite 19Respekt für Symmetrie

Physik-Nobelpreis 2008 für Entdeckung der spontanen Symmetriebrechung

Ahmed Ali • 12/2008 • Seite 22Der Schlüssel zum CP-Problem

Physik-Nobelpreis 2008: von Fermi zu Kobayashi und Maskawa

Stefan Jorda • 1/2008 • Seite 22Gala der Wissenschaft

Eindrücke von der Nobelpreisverleihung 2007 in Stockholm.

Eberhard Wassermann und Burkard Hillebrands • 12/2007 • Seite 23

Rieseneffekt in dünnen Schichten

Helmut Knözinger und Matthias Scheffler • 12/2007 • Seite 27

Expedition zwischen Physik und Chemie

Peter Grünberg • 9/2007 • Seite 33Kopplung macht den Widerstand

Im Zuge der rasanten technologischen Entwicklung rücken Daten auf einer Computer-Festplatte immer enger zusammen. Die immer kleineren und empfindlicheren Schreib- und Leseköpfe machen sich seit rund zehn Jahren den 1988 entdeckten Riesenmagnetowiderstand (GMR) zunutze. Darunter versteht man die große Änderung des elektrischen Widerstands eines magnetischen Schichtsystems, die auftritt, wenn die Magnetisierungen der einzelnen Schichten von antiparalleler auf parallele Orientierung gedreht werden. Schon kleine äußere Magnetfelder können die Orientierung verändern und machen GMR-Leseköpfe so empfindlich.

Eine englische Version des Artikels finden Sie hier (PDF).

Torsten A. Enßlin • 12/2006 • Seite 24Der Nachhall des Urknalls

Physik-Nobelpreis für Pionierleistungen in der Kosmologie

Wolfgang P. Schleich und Herbert Walther • 12/2005 • Seite 21

Kohärenz und Präzision

Siegfried Bethke und Peter Zerwas • 12/2004 • Seite 31

Schwache starke Wechselwirkung - die asymptotische Freiheit der Quarks

Rudolf P. Hübener, Mario Liu und Nils Schopohl • 12/2003 • Seite 23Symmetriebrechung und Quantenflüssigkeiten

Physik-Nobelpreis für Theorien zu Supraleitern und Supraflüssigkeiten

Axel Haase • 12/2003 • Seite 27Von der Kernphysik zur medizinischen Diagnostik

Medizin-Nobelpreis für Kernspintomographie

Till Kirsten und Joachim Trümper • 12/2002 • Seite 22Neue Fenster ins All

Den diesjährigen Nobelpreisträgern Raymond Davis jr. und Masatoshi Koshiba ist es erstmals gelungen, Neutrinos aus der Sonne und aus Supernovae nachzuweisen. Sie begründeten damit die experimentelle Neutrinoastrophysik, die seitdem aufregende fundamentale Beiträge zur Teilchenphysik liefert. Die zweite Hälfte des Nobelpreises erhält Ricardo Giacconi für seine Pionierarbeiten zur Röntgenastronomie, die sich zu einer tragenden Säule der Astrophysik und Kosmologie entwickelt hat.

• 12/2023 • Seite 22 • DPG-Mitglieder

• 12/2023 • Seite 22 • DPG-Mitglieder